| 送交者: 神游八荒[♂★★声望品衔10★★♂] 于 2022-06-30 20:20 已读 3596 次 | 神游八荒的个人频道 |

世界模型在实体机器人上能发挥多大的作用?

教机器人解决现实世界中的复杂任务,一直是机器人研究的基础问题。深度强化学习提供了一种流行的机器人学习方法,让机器人能够通过反复试验改善其行为。然而,当前的算法需要与环境进行过多的交互才能学习成功,这使得它们不适用于某些现实世界的任务。 6park.com

为现实世界学习准确的世界模型是一个巨大的开放性挑战。在最近的一项研究中,UC 伯克利的研究者利用 Dreamer 世界模型的最新进展,在最直接和最基本的问题设置中训练了各种机器人:无需模拟器或示范学习,就能实现现实世界中的在线强化学习。 6park.com

6park.com 论文链接: https://arxiv.org/pdf/2206.14176.pdf 6park.com

Dreamer 世界模型是谷歌、多伦多大学等机构在 2021 年提出的一种。如下图 2 所示,Dreamer 从过去经验的回放缓存中学习世界模型,从世界模型的潜在空间中想象的 rollout 中学习行为,并不断与环境交互以探索和改进其行为。研究者的目标是在现实世界中推动机器人学习的极限,并提供一个强大的平台来支持未来的工作。 6park.com

6park.com 总体来说,这项研究的贡献在于: 6park.com

1、Dreamer on Robots。研究者将 Dreamer 应用于 4 个机器人,无需引入新算法直接在现实世界中展示了成功的学习成果。这些任务涵盖了一系列挑战,包括不同的行动空间、感官模式和奖励结构。 6park.com

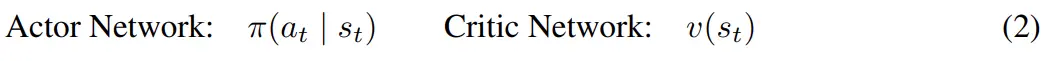

6park.com 2、1 小时内学会步行。研究者在现实世界中从零开始教四足机器人翻身、站起来并在 1 小时内学会步行。 6park.com

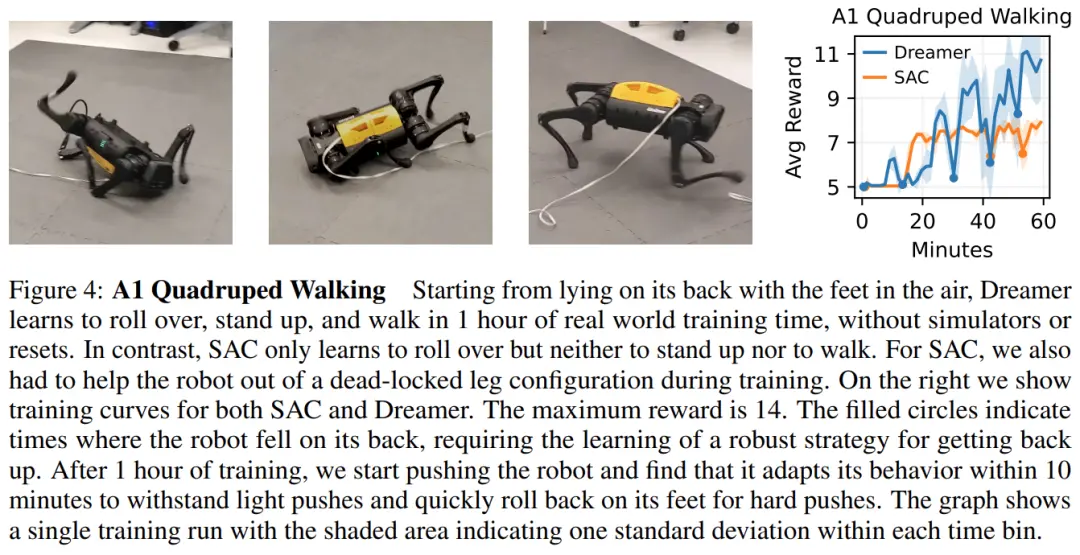

6park.com 此外,他们发现机器人会在 10 分钟内能学会承受推力或快速翻身并重新站起来。 6park.com

6park.com 3、视觉拾取和放置。研究者训练机械臂从稀疏奖励中学会拾取和放置对象,这需要从像素定位对象并将图像与本体感受输入融合。此处学习到的行为优于无模型智能体,并接近人类表现。 6park.com

6park.com 6park.com 4、开源。 研究者公开发布了所有实验的软件基础架构,它支持不同的动作空间和感官模式,为未来研究现实世界中机器人学习的世界模型提供了一个灵活的平台。 6park.com

方法 6park.com

该研究利用 Dreamer 算法(Hafner et al., 2019; 2020)在物理机器人上进行在线学习(online learning),无需模拟器,总体架构如上图 2 所示。Dreamer 从过去经验的回放缓冲区中学习世界模型,使用参与者 - 评价者算法从学习模型预测的轨迹中学习行为,并将其行为部署在环境中来不断提升回放缓冲区。 6park.com

该研究将学习更新与数据收集解耦,以满足延迟要求并实现快速训练而无需等待环境变化。在该研究的实现中,一个学习线程持续训练世界模型和参与者 - 评价者行为,同时一个参与者线程并行计算环境交互动作。 6park.com

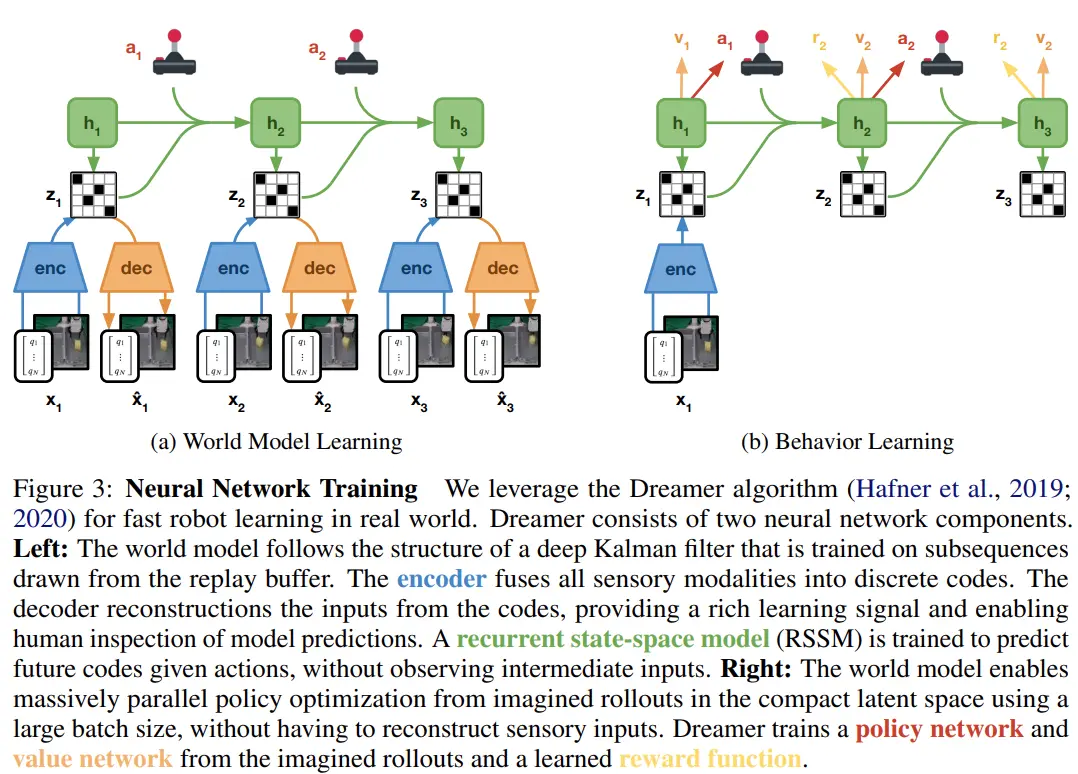

世界模型是一个学习预测环境动态的深度神经网络,如下图 3(a)所示。 6park.com

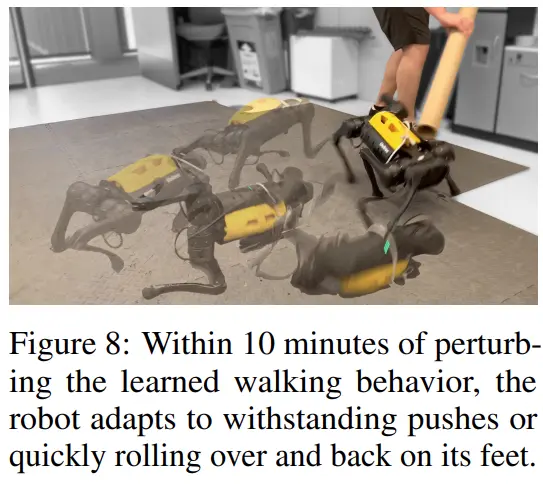

6park.com 世界模型可以被认为是机器人自主学习环境的快速模拟器,在探索现实世界时不断改进其模型。世界模型基于循环状态空间模型 (RSSM; Hafner et al., 2018),它由四个组件组成: 6park.com

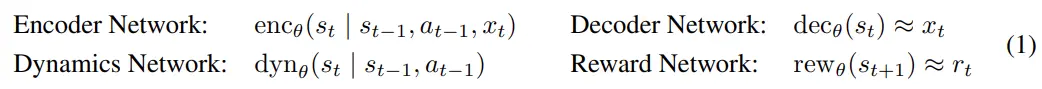

6park.com 世界模型表征了与任务无关的动态知识,而参与者 - 评价者算法负责学习特定于当前任务的行为。如上图 3(b) 所示。该研究从在世界模型的潜在空间中预测的 rollout 中学习行为,而无需解码观察结果。这可以在单个 GPU 上以 16K 的批大小进行大规模并行行为学习,类似于专门的现代模拟器 (Makoviychuk et al., 2021)。参与者 - 评价者算法由两个神经网络组成: 6park.com

6park.com 参与者网络的作用是为每个潜在模型状态 s_t 学习成功动作的分布,以最大化未来预测任务奖励(reward)的总和。评价者网络通过时间差异学习来学习预测未来任务奖励的总和(Sutton 和 Barto,2018 ),这允许算法学习长期策略。 6park.com

与 Hafner et al. (2020) 相比,Dreamer 方法没有训练频率超参数,因为学习器优化神经网络与数据收集并行进行,没有速率限制。 6park.com

实验 6park.com

研究者在 4 个机器人上评估了 Dreamer,为每个机器人分配了不同的任务,并将其性能与算法和人类基线进行比较,目的是评估近期学习世界模型的成功是否能够直接在现实世界中实现样本高效的机器人学习。 6park.com

这些实验代表了常见的机器人任务,例如运动、操纵和导航,带来了各种各样的挑战,包括连续和离散的动作、密集和稀疏的奖励、本体感受和图像观察,以及传感器融合。 6park.com

A1 机器狗四足步行 6park.com

如图 4 所示,经过一小时的训练,Dreamer 学会了不断地让机器人从其背部翻过来、站起来,然后向前走。在训练的前 5 分钟,机器人设法从背部翻滚过来并用脚着地。20 分钟后,它学会了如何站起来。大约 1 小时后,机器人学会了一种叉式步态,以所需的速度向前行走。 6park.com

6park.com 在成功完成这项任务后,研究者用一根棍子反复敲打机器人的四足来测试算法的鲁棒性,如图 8 所示。在额外在线学习的 10 分钟内,机器人会适应并承受推力或快速翻身站稳。相比之下,SAC 也很快学会了翻身,但由于数据预算(data budget)太小,无法站立或行走。 6park.com

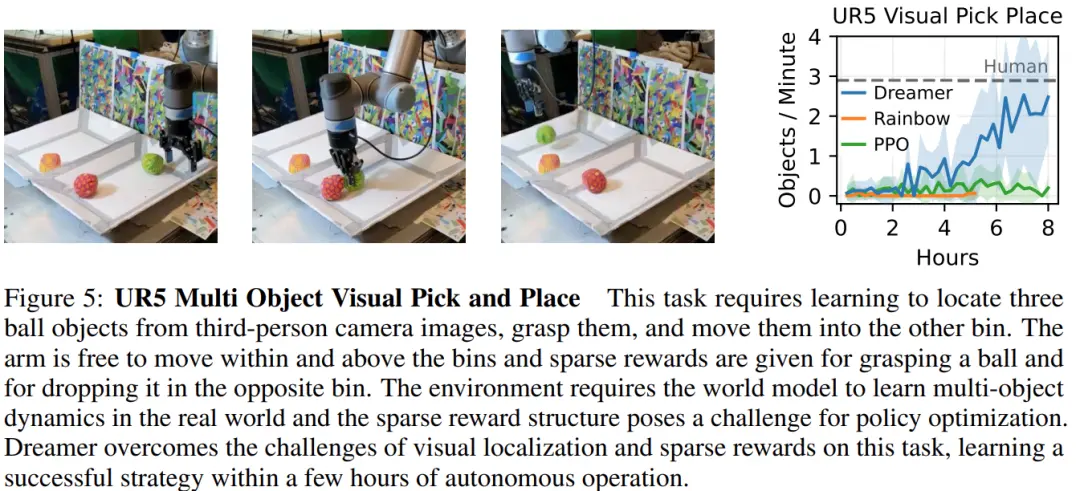

6park.com UR5 多物体视觉拾取和放置 6park.com

拾取和放置任务在仓库和物流环境中很常见,需要机械臂将物品从一个箱子运输到另一个箱子。图 5 展示了成功拾取和放置的循环。由于奖励稀疏、需要从像素推断对象位置以及多个移动对象的挑战性动态,该任务具有一定挑战性。 6park.com

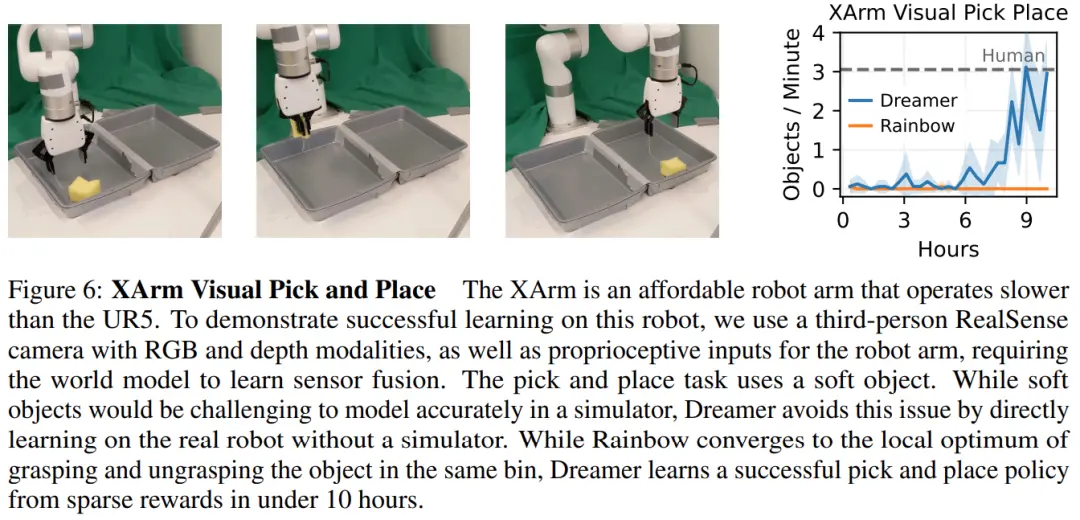

6park.com XArm 视觉拾取和放置 6park.com

上面提到的 UR5 机器人是高性能工业机器人,但 XArm 是一种可访问的低成本 7 DOF 操作,此处任务类似,需要定位和抓取一个柔软的物体,将其从一个容器移到另一个容器并返回,如图 6 所示。 6park.com

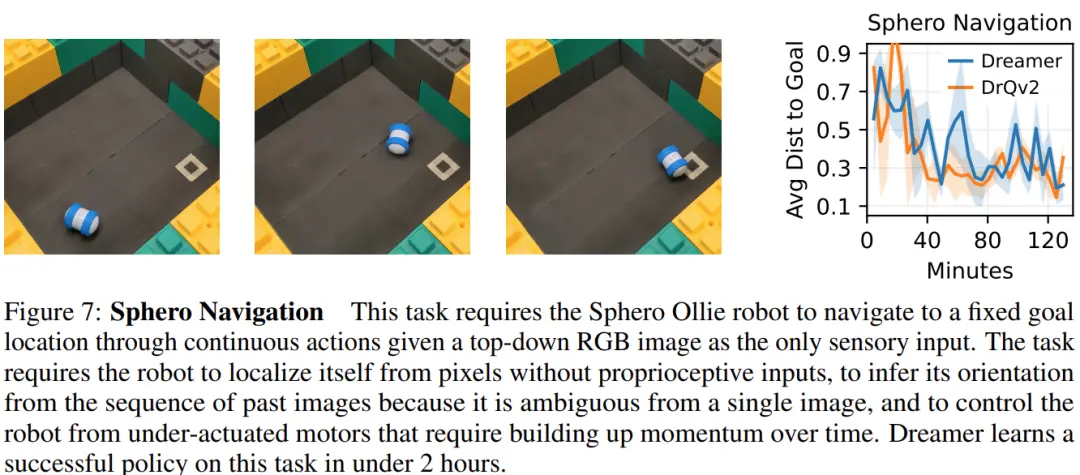

6park.com 6park.com Sphero 导航 6park.com

此外,研究者还在视觉导航任务上评估了 Dreamer,该任务需要将轮式机器人操纵到固定目标位置,仅给定 RGB 图像作为输入。这里使用了 Sphero Ollie 机器人,一个带有两个可控电机的圆柱形机器人,研究者通过 2 Hz 的连续扭矩命令对其进行控制。鉴于机器人是对称的,并且机器人只能获得图像观察,它必须从观察历史中推断出航向。 6park.com

6park.com 2 小时内,Dreamer 学会了快速且始终如一地导航到目标,并保持在目标附近。如图 7 所示,Dreamer 与目标的平均距离为 0.15(以区域大小为单位测量并跨时间步求平均值)。