| 送交者: PRChina[☆★★人民共和★★☆] 于 2019-08-15 16:43 已读 6088 次 9 赞 | PRChina的个人频道 |

按:看到有朋友谈到大数据,发现在我谈深度学习的旧文里没有提及,这是个疏忽,因为这对深度学习太重要了,所以补充几句。

----------------

我上一篇小文《漫谈机器学习》中提到了深度学习,https://web.6parkbbs.com/index.php?app=forum&act=view&bbsid=2010&tid=1123,废话不多说,今天我们就来聊一聊深度学习。深度学习(deep learning,DL)得到大众广泛关注是在2016年AlphaGO击败李世石之后。在次之前,也有不少人工智能的围棋软件,都无法挑战人类,而围棋也被人们视为棋类游戏的最后一个堡垒。从2016年到2017年短短数月,AlphaGO到AlphaGO Zero,棋力又突飞猛进,让人惊叹DL的学习能力。但DL对很多业外人士来说,只是个buzzword,并不真正理解DL的原理。这篇小文,我尽最大可能的把DL的原理简要介绍一下。

要讲DL就不能不提到神经网络(Neural Networks, NN)。NN早在20世纪4,50年代就被发明,为什么到今天才掀起热潮?DL与NN又有什么关系?介绍DL原理之前,我们先稍微了解一下DL的历史和这个领域的领军人物。下面这张照片就是DL界的四巨头,左二这位是Geoffrey Hinton,他可以称得上深度学习之父,多伦多大学的教授,谷歌的Fellow。左一这位是Yann LeCun,他是Hinton的嫡传弟子,纽约大学教授,非死不可AI研究院院长。右二这位是Yoshua Bengio,蒙特利尔大学的教授,2018年图灵奖的获得者。正是这三位推动了NN的发展,完成了到DL的演变。最后这位华裔面孔,是Andrew Ng,中文名叫吴恩达,斯坦福教授,曾经是百度的首席科学家,现在自己创业。他的主要贡献在于对DL的教育领域,很少有DL工程师或数据科学家没看过他的教学视频。DL领域里还有很多牛人,一大批后期之秀,我这里就不一一介绍了。

图1,DL四巨头合影

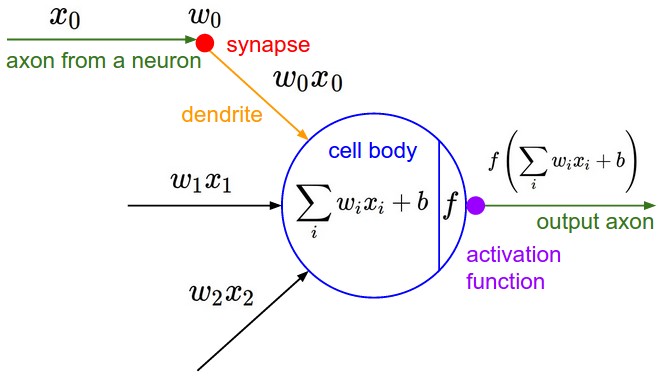

人工神经网络是受生物学对动物大脑的研究的启发,如下图所示,一个神经元细胞包含输入部分,细胞体处理输入刺激和输出部分。Warren McCulloch和Walter Pitts在1943年首先建立神经网络的计算模型如图3. 从这张图我们可以看出,和生物神经元细胞相似,人工神经元也有输入,处理和输出,而人工神经元的处理部分是用加权组合的方式把多个输入整合起来,经过一个激励方程,activation function后输出。这个激励方程通常是一种非线性方程,比如如果输出达到一定门限就输出1,未达到就输出0。神经元里加权的权值就是神经网络的参数,也是在训练神经网络时需要根据输入数据进行优化的。

图2,神经元细胞

图3,人工神经元的计算模型

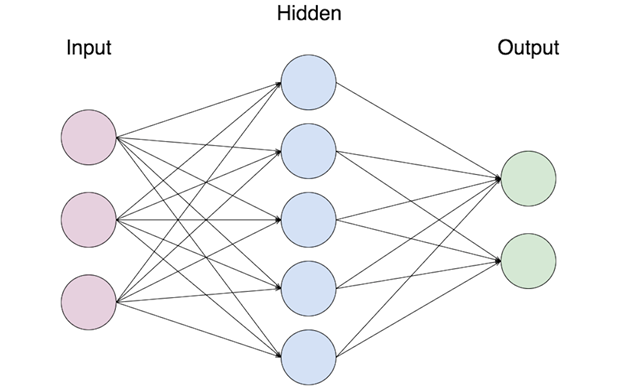

图4,神经网络简图把人工神经元组合在一起形成有层次的网络结构,如图4就是神经网络,最左第一层是输入层,最右第一层是输出层,中间层叫隐藏层。图4画了只有一个隐藏层,其实可以有很多隐藏层,如果两层或两层以上,就可以被称为深度网络啦。听上去很简单是不是?其实没那么简单。从其问世到7,80是年代,神经网络遭遇了第一个冬天,因为神经网络没有学习的能力,我们刚刚讲的神经网络的参数如何调整是关键。进入80年代,有些研究开始考虑用把误差反向传递(back-propagate errors)的方式来调整参数。所谓的BP,举个栗子,大家玩过猜商品价格的游戏,猜的人首先报个数字,被告知高了还是低了,然后作出相应的调整,再报出一个数字,以此类推直到猜中为止。然而并没有得到太多反响,是Hinton(巨头一)和他的两位同事在1986年的一篇文章Learning representations by back-propagating errors真正让BP的思想被学界接受,神经网络开始又得到广泛的关注。在接下来的十几年,神经网络蓬勃发展,衍生出卷积神经网络(Convolutional Neural Network,CNN),自编码NN等等。但是又出现了一个大问题,让神经网络陷入第二个冬天,BP貌似对深度网络不起作用,原因是一种叫梯度消失或爆炸问题的现象(gradient vanishing/explosion)。要把梯度扯清楚难免会带入一些数学,这里就不深入了,只要想想刚刚我们说的误差就是一种梯度(以均方差为代价函数时的梯度)。因为BP是以链式模式反向传递梯度的,每一层都要计算梯度并往前传递直到输入层,所以梯度是累乘的关系。当网络层数增加,梯度会以几何数衰减或爆炸。与此同时,其他的ML算法如支持向量机(Support Vector Machines)和随机森林(Random Forest)被广泛研究并发现优于神经网络,ML社区对于神经网络的热情逐步减退。热情减退意味着文章不好发项目资金不好拿。在这种不利情况下,Hinton,LeCun和Bengio坚持研究神经网络。终于,2006年,Hinton领导的小组发表突破性的文章A fast learning algorithm for deep belief nets,开启了深度学习的时代。这篇文章推翻了人们心中深度网络不可训练的偏执。而在另一方面,制约深度网络的另一要素,计算速度,随着处理器能力依照摩尔定律增长了几十倍,并且新的图像处理单元GPU被广泛的应用于DL中,大大地提高处理能力缩短了处理时间,以我的经验,数十倍之多。自此,深度学习一路高歌猛进,有发展出各个门类针对不同场景,比如CNN,Autoencoder,RNN,GAN,和GCN,同时DL的理论也在不断的累积,比如前文讲过的regularization如何防止overfitting,因为overfitting是DL的最大隐患;还有如何选取优化算法,如何选取激励函数等等,支系庞大,我这里就不细说了。建议初学者先从DL的理论入手,选择一个场景一种结构,使用一个熟知的数据,练习不同的训练技巧,加以时日,便会很快熟练。

最后总结,NN/DL自问世至今70多年,几起几落,现在占据了机器学习的大半壁江山(是不是像极了我们的邓公,哈哈),凭借的是几位巨匠甘于寂寞,不懈钻研,同时他们开宗立说积极教育,为DL社区培养了一批后起之秀。在此也以此小文表达我对他们的景仰。未来在各个AI应用领域中,比如对图像,文字,视频处理,DL会发挥越来越大的作用。接下来的几篇,我会写一些综述,介绍一下ML/DL在生物医学领域中的应用现状和发展前景,感谢关注。 6park.com

补充几句大数据与深度学习的关系:大数据已经成为buzzword好些年了,但对大众来说,究竟什么是大数据,大数据能如何改变我们的生活并不是非常清楚。我几年前听了一个IBM数据科学家的讲座,他说大数据的hype已经过去,接下来几年会进入一个低潮。但是这个低潮并没有很低,因为迎来了深度学习的hype,而大数据恰恰是DL的燃料。

所谓的大数据与其说是某种技术不如说是个现实问题以及能解决这个问题的一系列方法。不只是“大”,它有4个特性(后来发展出7个,我们只讲4个),被称为4Vs,是4个首写字母为V的单词:volumn,variety,velocity,veracity,即体量,多样,高速,参假。体量和速度不用说了,现在数据的规模是海量而且还在以指数在增长。多样性也容易理解,除了以前我们定义的可以被关系数据库存储的结构化数据,现在出现大量的图片,文字,视频等非结构性数据。veracity是指大数据中参杂很多不准确信息,过去数据量不大的情况下,可以人工手动去除可疑数据,大数据无法做到。这些特性都使传统的数据分析手段和机器学习算法难以满足要求,需要从数据存储,分析和表述各方面采用新的方法,而深度学习可以作为其分析的一个手段。比如说图片,可以看成2维的矩阵(如果是彩色图片就是3维tensor),过去的算法是把图片转化为1维向量(要么提取特征,要么直接reshape),然后进行归类;而深度学习中的卷积网络可以直接处理图片。最重要一点,深度学习的结构可以扩展,随数据量增加可以增加网络层数,这给了深度学习很大的灵活性;而且层数越多,参数越多,学习的容量就越大。有朋友说现在还无法区分“学习”还是“记忆”,这是没错的,毕竟记忆是学习的一部分。其实,我们讲overfitting就是容量大于所需要的容量,所以更多训练数据中的细节被记住,所以为了防止overfitting,我们要么减小学习容量,要么增加训练数据。大数据正好为深度学习提供大量训练所需的数据,也就是我前面所说的燃料。

欢迎转载,注明出处,谢谢!评分完成:已经给 PRChina 加上 1000 银元!

评分完成:已经给 PRChina 加上 1000 银元!